Sieci

UTK

Maj 2025 P W Ś C P S N « paź 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31

Ethernet

Ethernet – technika, w której zawarte są standardy wykorzystywane w budowie głównie lokalnych sieci komputerowych. Obejmuje ona specyfikację przewodów oraz przesyłanych nimi sygnałów. Ethernet opisuje również format ramek i protokoły z dwóch najniższych warstw Modelu OSI. Jego specyfikacja została podana w standardzie IEEE 802.3.

Ethernet jest najpopularniejszym standardem w sieciach lokalnych. Inne wykorzystywane specyfikacje to Token Ring, FDDIczy ARCNET.

Ethernet został opracowany przez Roberta Metcalfe’a w Xerox PARC czyli ośrodku badawczym firmy Xerox i opublikowany w roku 1976. Bazuje na idei węzłów podłączonych do wspólnego medium i wysyłających i odbierających za jego pomocą specjalne komunikaty (ramki). Wszystkie węzły posiadają niepowtarzalny adres MAC.

Klasyczne sieci Ethernet mają cztery cechy wspólne. Są to:

- parametry czasowe,

- format ramki,

- proces transmisji

- podstawowe reguły obowiązujące przy ich projektowaniu.

Standardem jest izolacja o wytrzymałości minimum 250 V~ między kablem a komputerem (niektóre firmy, np. 3Com, stosowały lepszą, co skutkowało dużo większą trwałością ich kart sieciowych).

Ramka sieci Ethernet

Istnieją 4 standardy ramek:

- Ethernet wersja 1 – już nieużywana,

- Ethernet wersja 2 (Ethernet II) – zwana też ramką DIX od firm DEC, Intel i Xerox, które opracowały wspólnie ten typ ramki i opublikowały w 1978. Jest ona w tej chwili najczęściej stosowana,

- IEEE 802.x LLC,

- IEEE 802.g LLC,

Ramki różnią się pomiędzy sobą długościami nagłówków, maksymalną długością ramki (MTU) i innymi szczegółami. Różne typy ramek mogą jednocześnie korzystać z tej samej sieci.

Budowa ramki Ethernet wersja 1:

- Preambuła – składająca się z 7 bajtów złożonych z naprzemiennych jedynek i zer:

10101010101010101010101010101010101010101010101010101010

co w zapisie szesnastkowym daje:

AAAAAAAAAAAAAA

Taki ciąg liczb pozwala na szybką synchronizację odbiorników.

- SFD – (ang. start frame delimiter), czyli znacznik początkowy ramki w postaci sekwencji 8 bitów (1 bajt):

10101011

w zapisie szesnastkowym

AB

- adres MAC odbiorcy (6 bajtów)

- adres MAC nadawcy (6 bajtów)

- typ (2 bajty) – jeżeli wartość jest równa lub większa od 1536 (w zapisie szesnastkowym 0x0600), to określa typ protokołu który jest używany, jeżeli mniejsza to oznacza długość danych w ramce

- dane (46 – 1500 bajtów) – jeżeli dane mniejsze niż 46 bajtów, to uzupełniane są zerami

- suma kontrolna (4 bajty) CRC.

Wczesne wersje Ethernetu

- Xerox Ethernet – oryginalna implementacja firmy Xerox używająca ramek formatu 1 i 2.

- 10BASE5 zwana też ang.Thicknet albo „gruby koncentryk” – standard z 1980 roku IEEE 802.3 używający grubego (12 mm) kabla koncentrycznego o impedancji falowej 50 Ω i żółtym kolorze (ten kabel – nazywany Yellow Ethernet Cable – produkowano specjalnie do tej sieci). Umożliwiał budowę segmentów o długości do 500 m. Obecnie już nie stosowany, ale czasami można spotkać jeszcze pracujące instalacje. Pracował z szybkością 10 Mb/s.

- 10BROAD36 – przestarzały, pracował na 75 Ω kablu TV.

- 1BASE5 – przestarzały, pracował z szybkością 1 Mb/s.

- StarLAN 1 – pierwsza implementacja kabla typu skrętka.

Wersje 10 Mb/s

- 10BASE2 zwany też ang. ThinNet, Cheapernet lub „cienki koncentryk” – używa kabla koncentrycznego RG-58 o impedancji 50 Ω i średnicy prawie 6 mm. Kabel musi biec pomiędzy wszystkimi kartami sieciowymi wpiętymi do sieci. Karty podłącza się za pomocą tzw. „trójnika”, do którego podpina się także kabel za pomocą złącz BNC. Na obu końcach kabla montowany jest rezystor (tzw. terminator) o rezystancji 50 Ω. Maksymalna długość segmentu wynosiła 185 m. chociaż rozwiązania niektórych firm np. 3Com dopuszczały 300 m. Przez wiele lat była to dominująca forma sieci Ethernet. Jej wadą było to, że uszkodzenie kabla w jednym miejscu powodowało zanik dostępu do sieci w całym segmencie (dotykało wszystkie komputery). Niewątpliwą zaletą była niska cena, wynikała ona przede wszystkim z braku niegdyś bardzo kosztownego huba sieciowego, jak też z faktu, że początkowo karty na skrętkę były droższe od kart z wejściem koncentrycznym, podobnie kabel.

- StarLAN 10 – pierwsza implementacja kabla typu skrętka przy szybkości 10 Mb/s.

- 10Base-T – pracuje na 4 żyłach (2 pary skrętki) kategorii 3 lub 5. Każda karta sieciowa musi być podłączona do huba lub switcha.

W standardzie 10Base-T nie określono limitu długości kabla. Zamiast tego standaryzacji poddano parametry, które musi spełniać połączenie sieciowe. W efekcie standardowa, nieekranowana skrętka daje zasięg do około 110 metrów (niektóre źródła podają również wartość 105 metrów). Kable wysokiej jakości mogą pracować na odcinkach o długości 150 metrów lub dłuższych. Właściwości połączenia można sprawdzić odpowiednim testerem. W przeciwieństwie do 10BASE2 awaria kabla w jednym miejscu powodowała zanik dostępu do sieci tylko jednego komputera dlatego 10Base-T wyparł 10Base2.

- FOIRL (ang. Fiber-optic inter-repeater link) – pierwotny standard Ethernetu za pomocą światłowodu.

- 10BASE-F – rodzina standardów 10BASE-FL, 10BASE-FB i 10BASE-FP Ethernetu; łączenie za pomocą światłowodu.

- 10BASE-FL – ulepszony standard FOIRL. Jedyny z szeroko stosowanych z rodziny 10BASE-F.

- 10BASE-FB – przeznaczony do łączenia hubów lub switchy; przestarzały.

- 10BASE-FT – do sieci nie wymagających elementów aktywnych (hubów, switchy); łączenie za pomocą światłowodu; nigdy nie zaimplementowany.

| xd | ||||||

Fast Ethernet

- 100Base-TX – podobny do 10BASE-T, ale z szybkością 100 Mb/s. Wymaga 2 par z 4 parowej skrętki kategorii 5, używa wtyków 8P8C (błędnie nazywanymi RJ-45). Obecnie jeden z najpopularniejszych standardów sieci opartych na skrętce.

- 100Base-T4 – Używa 4 par skrętki kategorii 3. Obecnie przestarzały.

- 100Base-T2 – Miał używać 2 par skrętki kategorii 3 jednak nie ma sprzętu sieciowego wspierającego ten typ Ethernetu.

- 100BASE-FX – Ethernet 100 Mb/s za pomocą włókien światłowodowych wielomodowych. Zasięg rozwiązania wynosi do 2 km.

- 100Base-LX – Ethernet 100 Mb/s za pomocą włókien światłowodowych.

- 100Base-LX10 – Ethernet 100 Mb/s za pomocą włókien światłowodowych jedno i wielomodowych. Zasięg dla jednomodów wynosi 10 km, dla wielomodów 550 m.

- 100Base-SX – Ethernet 100 Mb/s za pomocą włókien światłowodowych wielomodowych. Zasięg około 460 m.

- 100Base-CX – Ethernet 100 Mb/s za pomocą 2 par skrętki. Zasięg około 25 m.

Standard Fast Ethernet jest obecnie jednym z najpopularniejszych sieci Ethernet. Jest to sieć znacznie szybsza od Ethernetu, z powodu używania standardowo przełączników pakietów zamiast hubów, dzięki czemu nie ma kolizji w dużych sieciach. Powoli jest wypierany przez Gigabit Ethernet.

Gigabit Ethernet

- 1000BASE-T – 1 Gb/s na kablu miedzianym – popularnej skrętce kategorii 5/5e lub wyższej. Ponieważ jedna para skrętki w kablu kategorii 6 może bez strat przenosić do 125 Mb/s (zasięg do 100 m), osiągnięcie 1000 Mb/s wymaga użycia 4 par oraz modyfikacji układów transmisyjnych dającej możliwość transmisji ok. 250 Mb/s na jedną parę w skrętce.

- 1000BASE-SX – 1 Gb/s na światłowodzie (do 550 m).

- 1000BASE-LX – 1 Gb/s na światłowodzie. Zoptymalizowany dla połączeń na dłuższe dystanse (do 10 km) za pomocą światłowodów jednomodowych.

- 1000BASE-LH – 1 Gb/s na światłowodzie (do 10 km).

- 1000BASE-CX – 1 Gb/s na specjalnym kablu miedzianym zwanym kablem koncentrycznym na odległość do 25 m używany kiedyś do łączenia ze sobą koncentratorów, przełączników. Obecnie przestarzały i wyparty przez 1000BASE-T.

10 Gigabit Ethernet

- 10GBASE-SR – 10 Gb/s przeznaczony dla światłowodów wielomodowych o maksymalnym zasięgu od 26 do 82 m (przy 850 nm). Umożliwia także zasięg 300 m na nowych światłowodach wielomodowych 2000 MHz/km.

- 10GBASE-LX4 – stosuje multipleksację typu WDM umożliwia zasięg 240 lub 300 m za pomocą światłowodów wielomodowych (przy 1310 nm) lub 10 km za pomocą jednomodowych.

- 10GBASE-LR – Ethernet za pomocą światłowodów jednomodowych na odległość 10 km.

- 10GBASE-ER – Ethernet za pomocą światłowodów jednomodowych na odległość 40 km.

- 10GBASE-ZR – Ethernet za pomocą światłowodów jednomodowych na odległość 80 km.

- 10GBASE-SW, 10GBASE-LW i 10GBASE-EW – odpowiedniki 10GBASE-SR, 10GBASE-LR i 10GBASE-ER używające transmisji synchronicznej na tych samych typach światłowodów i na te same odległości.

- 10GBASE-T – najnowszy standard w tej kategorii. Umożliwia transmisję o prędkości 10 Gb/s na odległość 100 m kablem kategorii 6A. Możliwe jest również wykorzystanie kabla kategorii 6 – wtedy maksymalna długość kabla nie powinna przekraczać 55 m.

100 Gigabit Ethernet

23 listopada 2006 r. naukowcy z IEEE rozpoczęli prace nad opracowaniem technologii, która umożliwiałaby wprowadzenie nowego standardu sieci Ethernet o prędkości do 100 Gb/s. W czerwcu 2010 roku standard ten (802.3ba) został zaakceptowany przez IEEE.

Inne standardy

- standardy dla WLAN – opisane w IEEE 802.11. Wymiana danych z szybkościami od 1 do 6928 Mb/s za pomocą urządzeń radiowych.

- 100BaseVG – standard zaproponowany przez firmę Hewlett-Packard o szybkości 100 Mb/s na 2 parach skrętki kategorii 3. Nie zdobył uznania.

Źródło:https://pl.wikipedia.org/wiki/Wikipedia:Strona_g%C5%82%C3%B3wna

Opublikowano Bez kategorii

Skomentuj

Dysk twardy

Dysk twardy, dysk komputerowy, HDD (od ang. hard disk drive, napęd dysku twardego) – pamięć masowa wykorzystująca nośnik magnetyczny do przechowywania danych. Nazwa „dysk twardy” wynika z zastosowania twardego materiału jako podłoża dla właściwego nośnika, w odróżnieniu od dysku miękkiego, w którym nośnik magnetyczny nanoszono na podłoże elastyczne.

Pojemność dysków twardych w komputerach stacjonarnych wynosi od 5 MB (dawniej) do 16 TB, natomiast w laptopach od 20 do 4000 GB. Opracowano również miniaturowe dyski twarde typu microdrive, o pojemnościach od kilkuset MB do kilku GB, przeznaczone dla cyfrowych aparatów fotograficznych i innych urządzeń przenośnych.

Dla dysków twardych najważniejsze są następujące parametry: pojemność, szybkość transmisji danych, czas dostępu do danych, prędkość obrotowa dysków magnetycznych (obr./min) oraz średni czas bezawaryjnej pracy.

Kilka dysków twardych można łączyć w macierz dyskową, dzięki czemu można zwiększyć niezawodność przechowywania danych, dostępną przestrzeń na dane, zwiększyć szybkość odczytu/zapisu

Użycie sztywnych talerzy i uszczelnienie jednostki umożliwia większą precyzję zapisu niż na dyskietce, w wyniku czego dysk twardy może zgromadzić o wiele więcej danych niż dyskietka. Ma również krótszy czas dostępu do danych i szybszy transfer.

Bardzo stare dyski twarde można było uszkodzić znacznie łatwiej niż dyskietki. Samo używanie mocnych perfum w pobliżu mogło tego dokonać.

- 4 września 1956 przedsiębiorstwo IBM skonstruowało pierwszy 24-calowy dysk twardy o nazwie RAMAC 350. Miał on pojemność 5 MB.

- W 1980 przedsiębiorstwo Seagate wprowadziło na rynek pierwszy dysk 5,25″, ST-506 o pojemności 5 MB.

- W 1983 pojawiły się komputery IBM PC/XT z dyskami 5 i 10 MB.

- W 1986 został opracowany kontroler IDE (integrated drive electronics).

- W 1987 rozpoczęła się era dysków 3,5 cala.

- W 2003 dysk twardy w typowym stanowisku pracy mógł zgromadzić od 60 do 500 GB danych, obracać się z prędkością 5400 do 10 000 obrotów na minutę (taka prędkość obrotowa jest możliwa dzięki zastosowaniu łożyskowania FDB). W wydajnych serwerach i stacjach roboczych z wyższej półki stosowane były dyski SCSI o prędkościach obrotowych na poziomie 15.000 obrotów na minutę.

- W 2006 dzięki technologii zapisu prostopadłego możliwe jest przetrzymywanie na dysku ponad 1 TB danych. Standardem staje się złącze SATA i SAS oraz technologia optymalizacji odczytu NCQ. Stacje dyskietek zaczęły przegrywać z pamięciami USB do których złącza montuje się z przodu obudowy.

- W 2008 pojawiły się dyski półprzewodnikowe (SSD). Na początku technologia ta była bagatelizowana przez dużych producentów, jednak stosunkowo duże zainteresowanie rynku (mimo początkowo bardzo wysokiej ceny), duża wydajność (dzięki minimalnemu czasowi dostępu do danych) oraz malejąca cena za MB szybko zmieniła ich nastawienie.

- Na początku 2009 wyprodukowane zostały dyski o pojemność 2 TB. Producent WD wypuścił serię dysków Green, czyli ekologicznych o dynamicznej zmianie prędkości obrotowych. Rozwijany jest standard SATA 3 na potrzeby dysków półprzewodnikowych.

- W październiku 2010 Western Digital wyprodukował dysk twardy Caviar Green o pojemności 3 TB.

- Pod koniec 2011 Hitachi wyprodukowało dysk twardy o pojemności 4 TB.

- Od marca 2012 na rynku pozostało jedynie trzech producentów dysków twardych: Western Digital, Seagate Technology i Toshiba.

- W marcu 2013 Seagate Technology uzyskiwało sprzedaż na poziomie nawet ośmiu dysków na sekundę i jako pierwsza uzyskała całkowitą sprzedaż dysków przekraczającą dwa miliardy sztuk.

- W listopadzie 2013 Western Digital pokazał dysk o pojemności 6 TB wypełniony helem, który w porównaniu do dysku wypełnionego powietrzem pobierał o 49% mniej energii, w przeliczeniu na jeden TB pojemności.

- W 2014 Western Digital zaprezentowało pierwszy dysk 10TB

- W marcu 2017 Western Digital zapowiedział dyski o pojemności od 12 do 14 TB.

- W grudniu 2018 Seagate zaprezentował dysk o pojemności 16 TB A w czerwcu 2019 wprowadził do sprzedaży

- We wrześniu 2019 WD zaprezentowało dyski twarde o pojemności 18 TB i 20 TB

W przyszłości

- Seagate do 2020 roku dostarczy HDD o pojemności 20 TB, 50 TB w ciągu dekady

- Viking UHC-Silo SSD – dyski SSD o pojemności 25 i 50 TB

- Seagate zapowiada 100 TB dyski HDD dzięki technologii HAMR 2025/2026 roku

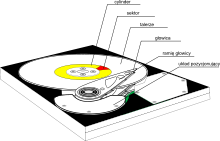

Budowa

Dysk twardy składa się z zamkniętego w obudowie, wirującego talerza (dysku) lub zespołu talerzy, wykonanych najczęściej z warstwy szkła pokrytej cienką warstwą metalu, o wypolerowanej powierzchni, oraz nośnikiem magnetycznym o grubości kilku mikrometrów, oraz z głowic elektromagnetycznych umożliwiających zapis i odczyt danych. Na każdą powierzchnię talerza dysku przypada po jednej głowicy odczytu i zapisu. Głowice są umieszczone na ruchomych ramionach i w stanie spoczynku stykają się z talerzem blisko jego osi. W czasie pracy unoszą się, a ich odległość nad talerzem jest stabilizowana dzięki sile aerodynamicznej powstałej w wyniku szybkich obrotów talerza. Jest to najpopularniejsze obecnie rozwiązanie (są też inne sposoby prowadzenia głowic nad talerzami).

Ramię głowicy dysku ustawia głowice w odpowiedniej odległości od osi obrotu talerza w celu odczytu lub zapisu danych na odpowiednim cylindrze. Pierwsze konstrukcje (do ok. 200MB) były wyposażone w silnik krokowy, stosowany uprzednio w stacjach dyskietek. Wzrost liczby cylindrów na dysku oraz konieczność zwiększenia szybkości dysków wymusił wprowadzenie innych rozwiązań. Najpopularniejszym obecnie jest tzw. voice coil, czyli cewka wzorowana na układzie magnetodynamicznym stosowanym w głośnikach. Umieszczona w silnym polu magnetycznym cewka porusza się i zajmuje położenie zgodnie z przepływającym przez nią prądem, ustawiając ramię w odpowiedniej pozycji. Dzięki temu czas przejścia między kolejnymi ścieżkami jest nawet krótszy niż 1 milisekunda, a przy większych odległościach nie przekracza kilkudziesięciu milisekund. Układ regulujący prądem zmienia natężenie prądu, tak by głowica ustabilizowała jak najszybciej swe położenia w zadanej odległości od środka talerza (nad wyznaczonym cylindrem).

Informacja jest zapisywana na dysk przez przesyłanie strumienia elektromagnetycznego przez antenę albo głowicę zapisującą, która jest bardzo blisko magnetycznie polaryzowalnego materiału, zmieniającego swoją polaryzacją magnetyczną wraz ze strumieniem indukcji magnetycznej, informacja może być z powrotem odczytana w odwrotny sposób, gdyż zmienne pole magnetyczne powoduje indukowanie napięcia elektrycznego w cewce głowicy lub zmianę oporu w głowicy magnetyczno-oporowej.

Ramiona połączone są zworą i poruszają się razem. Zwora kieruje głowicami promieniowo po talerzach a w miarę rotacji talerzy, daje każdej głowicy dostęp do całości jej talerza.

Zintegrowana elektronika kontroluje ruch zwory, obroty dysku, oraz przygotowuje odczyty i zapisy na rozkaz od kontrolera dysku. Nowoczesne układy elektroniczne są zdolne do skutecznego szeregowania odczytów i zapisów na przestrzeni dysku oraz do zastępowania uszkodzonych sektorów zapasowymi.

Obudowa chroni części napędu od pyłu, pary wodnej, i innych źródeł zanieczyszczenia. Jakiekolwiek zanieczyszczenie głowic lub talerzy może doprowadzić do uszkodzenia głowicy (head crash), awarii dysku, w której głowica uszkadza talerz, ścierając cienką warstwę magnetyczną. Awarie głowicy mogą również być spowodowane przez błąd elektroniczny, uszkodzenie, błędy produkcyjne dysku.

Dysk RAM

Dyski RAM to urządzenia emulujące dyski, w których do zapisu danych stosuje się rozwiązania wykorzystujące popularne pamięci RAM, dzięki którym osiąga się krótki czas dostępu i bardzo szybki transfer danych, którego wartości przekraczają przepustowość oferowaną przez typowe interfejsy dla dysków twardych, takie jak Ultra ATA czy Serial ATA. Dysków RAM nie należy mylić z coraz popularniejszymi dyskami półprzewodnikowymi (SSD): różnica polega na rodzaju pamięci krzemowej (Flash ROM vs dynamic RAM). Dyski RAM mają mniejsze pojemności i są zdecydowanie droższe. Zasadniczą wadą takich dysków jest utrata zapisanych danych przy zaniku napięcia (np. przy wyłączeniu komputera), dlatego też stosuje się pomocnicze źródła prądu podtrzymujące pracę dysków: wbudowane akumulatory i zewnętrzne zasilacze.

Dotychczas zaproponowane rozwiązania to:

- dysk zabudowany na karcie PCI (dysk iRAM`)

- dysk w standardowej obudowie 5,25″

- dysk na karcie rozszerzeń ISA, zawierający własne akumulatory oraz gniazdo niewielkiego zewnętrznego zasilacza podtrzymującego układy i ładującego akumulatory.

Strategie szeregowania zadań

- FIFO – (ang. first in, first out) żądania są przetwarzane sekwencyjnie wg kolejki. Pierwsze żądanie w kolejce jest obsługiwane jako pierwsze. Sprawiedliwa strategia nieprowadząca do zagłodzenia, ruchy głowicy losowe przy wielu procesach, mała wydajność.

- Priorytet – mniejsze zadania uzyskują wyższy priorytet i są wykonywane szybciej, dobry czas reakcji. Nie optymalizuje wykorzystania dysku, lecz wykonanie zadań.

- LIFO – (ang. last in, first out) ostatni na wejściu i pierwszy na wyjściu. Ryzyko zagłodzenia przy dużym obciążeniu, poprawia przepustowość i zmniejsza kolejki.

- SSTF – (ang. shortest service time first) najpierw obsługiwane jest żądanie, przy którym są najmniejsze ruchy głowicy; dobra wydajność, ryzyko zagłodzenia.

- SCAN – ramię „skanuje” dysk, realizując napotkane na swojej drodze żądania, a gdy dotrze do ostatniej ścieżki, wówczas zaczyna skanować dysk w drugą stronę.

- C-SCAN – skanowanie tylko w jednym kierunku. Po osiągnięciu końca ścieżki ramię wraca na przeciwny koniec dysku i zaczyna skanowanie w tym samym kierunku.

- N-step-SCAN – żądania są ustawiane w podkolejkach od długości N. Każda podkolejka jest przetwarzana zgodnie ze strategią SCAN. Dla dużego N zbliża się do SCAN, dla N = 1 jest to FIFO.

- FSCAN – dwie podkolejki. Gdy skanowanie się rozpoczyna, żądania są umieszczone w pierwszej podkolejce. Żądania pojawiające się w czasie skanowania są ustawiane do drugiej podkolejki i przetwarzane po zakończeniu skanowania zadań z pierwszej podkolejki.

Sposoby adresowania danych na dysku

- CHS (cylinder, head, sector)

- ECHS (Extended cylinder, head, sector)

- LBA (Logical Block Adressing)

- MZR (Multiple Zone Recording)

- CKD Count Key Data (w komputerach mainframe)

- ECKD Enhanced CKD

Jako główną linię podziału można podać FBA (Fixed Block Address) – CKD (Count Key Data), przy czym wszystkie komputery poza maszynami klasy mainframe używają obecnie dysków FBA. Przez wiele lat dyski FBA miały jednakowy rozmiar sektora wynoszący 512 bajtów (netto + 8 B na sektor ID), obecnie przy pojemnościach terabajtowych, producenci przechodzą na większe rozmiary sektora, które są obsługiwane przez relatywnie najnowsze wersje systemów operacyjnych. Dyski CKD są nadal z powodzeniem używane przez instalacje mainframe, przy czym od kilkunastu lat są to wyłącznie dyski emulowane przez macierze dyskowe

Źródło:https://pl.wikipedia.org/wiki/Wikipedia:Strona_g%C5%82%C3%B3wna

Opublikowano Bez kategorii

Skomentuj

RAM

RAM (od ang. random-access memory), pamięć o dostępie swobodnym – podstawowy rodzaj pamięci cyfrowej. Choć nazwa sugeruje, że jest to każda pamięć o bezpośrednim dostępie do dowolnej komórki pamięci (w przeciwieństwie do pamięci o dostępie sekwencyjnym, na przykład rejestrów przesuwnych), ze względów historycznych oznacza ona tylko te rodzaje pamięci o bezpośrednim dostępie, w których możliwy jest wielokrotny i łatwy zapis, a wyklucza pamięci ROM (tylko do odczytu) i EEPROM, w których zapis trwa znacznie dłużej niż odczyt, mimo że w ich przypadku też występuje swobodny dostęp do zawartości[1].

W pamięci RAM przechowywane są aktualnie wykonywane programy i dane dla tych programów oraz wyniki ich pracy. W temperaturze pokojowej zawartość większości pamięci RAM jest tracona w czasie mniejszym niż sekunda po zaniku napięcia zasilania, niektóre typy wymagają także odświeżania, dlatego wyniki pracy programów wymagające trwałego przechowania muszą być zapisane na innym nośniku danych.

Pamięci RAM dzieli się na pamięci statyczne (ang. static random-access memory, w skrócie SRAM) oraz pamięci dynamiczne (ang. dynamic random-access memory, w skrócie DRAM). Pamięci statyczne są szybsze od pamięci dynamicznych, które wymagają ponadto częstego odświeżania, bez którego szybko tracą swoją zawartość. Obok swoich zalet są one jednak dużo droższe; używane są w układach, gdzie wymagana jest duża szybkość (np. pamięć podręczna procesora) lub ilość pamięci jest niewielka, więc nie opłaca się konstruować układu odświeżania (np. prostemikrokontrolery). W komputerach wymagających dużej ilości pamięci jako pamięć operacyjną używa się pamięci DRAM.

Pamięć RAM jest stosowana głównie jako pamięć operacyjna komputera, jako pamięć niektórych komponentów (procesorów specjalizowanych) komputera (kart graficznych, kart dźwiękowych), jako pamięć danych sterowników mikroprocesorowych.

Technologie pamięci RAM

Współczesna pamięć RAM jest realizowana sprzętowo w postaci układów scalonych występujących w różnych technologiach lub jako fragmenty bardziej złożonych scalonych układów cyfrowych (np. pamięć cache L1, L2 procesora, a ostatnio także L3) oraz w postaci różnych modułów, znajdujących głównie zastosowanie w komputerach. Wyróżnia się pamięci trwałe i ulotne.

Pamięci trwałe

- FRAM – nośnikiem danych jest kryształ

- MRAM – nośnikiem danych są magnetyczne złącza tunelowe (konstrukcja prototypowa)

- NRAM (nanotube random-access memory) – pamięć zbudowana z nanorurek węglowych (konstrukcja eksperymentalna)

- PRAM – elementem pamięciowym jest kryształ (konstrukcja prototypowa)

Rozwój modułów pamięci używanych w komputerach osobistych

Jeśli chodzi o komputery zgodne z IBM PC, to obecnie oferują ponad milion razy większą pojemność niż w pierwszym IBM PC 5150 który był oferowany z 16 KB RAMu, a obecnie(2018) zgodne z IBM PC mają instalowane nawet 16GB RAMu.

Źródło:https://pl.wikipedia.org/wiki/Wikipedia:Strona_g%C5%82%C3%B3wna

Opublikowano Bez kategorii

Skomentuj

Płyta główna

Płyta główna (ang. motherboard, mainboard) – obwód drukowany urządzenia elektronicznego, na którym montuje się najważniejsze elementy, umożliwiając komunikację wszystkim pozostałym komponentom i modułom.

W komputerze na płycie głównej znajdują się: procesory, pamięć operacyjna lub gniazda do zainstalowania tych urządzeń oraz gniazda do zainstalowania dodatkowych płyt zwanych kartami rozszerzającymi (np. PCI), oraz gniazda do urządzeń składujących (dyski twarde, napędy optyczne itp.), złącze klawiatury i zasilacza. W niektórych konstrukcjach także gniazda do innych urządzeń zewnętrznych, do których sprzęt znajduje się na płycie głównej (port szeregowy, port równoległy, USB).

Koncepcję zbudowania komputera osobistego wyposażonego tylko w minimum potrzebnych urządzeń zmontowanych na jednej płycie drukowanej oraz gniazd, do których podłącza się dodatkowe urządzenia, zapoczątkowała firma IBM, wprowadzając komputer osobisty, zwany też PC.

Budowa płyty głównej komputera typu PC

W miarę wzrostu stopnia integracji układów scalonych, w celu poprawy szybkości działania oraz obniżenia kosztów budowy całego komputera postępuje integracja elektroniki komputera w kilku układach scalonych umożliwiających współpracę procesora z innymi układami.

W konfiguracjach dominujących w pierwszej dekadzie XXI wieku większość urządzeń zrealizowanych na płycie głównej zgrupowana jest w dwóch układach scalonych zwanych mostkami. Bliższy procesorowi zwany mostkiem północnym oraz mostek południowy.

Mostek północny jest połączony z procesorem za pomocą magistrali FSB lub łączyHyper Transport. W nowszych rozwiązaniach układ ten zawiera podstawowy kontroler PCIe (lub w starszych rozwiązaniach – AGP), służący najczęściej do podłączenia urządzeń z rodzaju kart graficznych (także zintegrowanych), ale też wszelkich urządzeń wymieniających z procesorem lub pamięcią duże ilości danych (bardzo często zintegrowane karty sieciowe).

Mostek południowy (jeśli występuje) jest podłączony do mostka północnego za pomocą magistrali (na przykład FSB) albo łączem typu Punkt-Punkt jak Hyper Transport. Zawiera drugi kontroler PCIe, kontrolery SATA, ATA, USB, zintegrowany kontroler dźwięku (np. AC97), kontrolery Ethernetu, itd… Jeśli na płycie głównej występuje tylko jeden układ, to najczęściej wszystkie funkcje mostka południowego i północnego są w nim zintegrowane.

Poza wyżej wymienionymi elementami na płycie głównej zawsze jest umieszczony układ BIOS-u, a także moduł zegara czasu rzeczywistego (RTC) wraz z modułem bateryjnego podtrzymania zegara.

Źródło:https://pl.wikipedia.org/wiki/Wikipedia:Strona_g%C5%82%C3%B3wna

Opublikowano Bez kategorii

Skomentuj

Karta graficzna

Karta graficzna – karta rozszerzeń komputera odpowiedzialna za renderowanie grafiki i jej konwersję na sygnał zrozumiały dla wyświetlacza.

Spis treści

Historia

Pierwsze karty graficzne potrafiły jedynie wyświetlać znaki alfabetu łacińskiego ze zdefiniowanego w pamięci karty generatora znaków – tryb tekstowy. Kolejna generacja kart graficznych potrafiła już wyświetlać w odpowiednim kolorze poszczególne punkty (piksele) – tryb graficzny. Nowoczesne procesory graficzne udostępniają wiele funkcji ułatwiających i przyśpieszających pracę programów. Możliwe jest narysowanie odcinka, trójkąta, wieloboku, wypełnienie ich zadanym kolorem lub wzorem, tzw. akceleracja 2D. Większość kart na rynku posiada również wbudowane funkcje ułatwiające tworzenie obrazu przestrzeni trójwymiarowej, tzw. akceleracja 3D. Niektóre posiadają zaawansowane algorytmy potrafiące na przykład wybrać tylko widoczne na ekranie elementy z przestrzeni. W nowych układach graficznych zrezygnowano ze sztywnego schematu obliczeń, dając użytkownikowi pewną ilość jednakowych „rdzeni”, które może on sobie zaprogramować (przy pomocy shaderów) do wyświetlania dowolnych efektów graficznych. Umożliwia to też wykorzystanie karty graficznej jako procesora ogólnego przeznaczenia (GPGPU), zdolnego do przeliczania dużych zbiorów uporządkowanych danych.

Typy

Wyróżniamy dwa typy procesorów karty graficznej:

Przystosowane do pracy jako oddzielne karty graficzne tzw. dedykowane:

- procesory serii Radeon Graphics produkowane przez ATI technologies, marka AMD

- procesory serii GeForce produkowane przez Nvidia

- procesory firmy Matrox

- procesory firmy XGI Technology

Zintegrowane z mostkiem północnym lub bezpośrednio w CPU:

- procesory marki Intel GMA

- procesory firmy AMD

- procesory firmy SiS

- procesory firmy VIA Technologies

Historyczne różnice w terminologii

Wraz z pojawieniem się kart Voodoo firmy 3dfx, które znacznie przyspieszały wyświetlanie grafiki trójwymiarowej, pojawił się termin akcelerator graficzny. Karty te wymagały bowiem obecności w komputerze zwykłej karty graficznej.

Pozostali producenci zdecydowali się na integrację akceleratorów grafiki trójwymiarowej z samymi kartami graficznymi, podobnie jak to miało miejsce z akceleratorami grafiki dwuwymiarowej. Później także firma 3dfx zdecydowała się zintegrować swoje akceleratory z kartami graficznymi.

Źródło:https://pl.wikipedia.org/wiki/Wikipedia:Strona_g%C5%82%C3%B3wna

Opublikowano Bez kategorii

Skomentuj

Procesor

Procesor, CPU (ang. central processing unit) – sekwencyjne urządzenie cyfrowe, które pobiera dane z pamięci operacyjnej, interpretuje je i wykonuje jako rozkazy. Procesory wykonują ciągi prostych operacji matematyczno-logicznych ze zbioru operacji podstawowych.

Procesory wykonywane są zwykle jako układy scalone zamknięte w hermetycznej obudowie, często posiadającej złocone wyprowadzenia (stosowane ze względu na odporność na utlenianie) i w takiej postaci nazywa się je mikroprocesorami – w mowie potocznej pojęcia procesor i mikroprocesor używane są zamiennie. Sercem procesora jest monokryształ krzemu, na który naniesiono techniką fotolitografii szereg warstw półprzewodnikowych, tworzących, w zależności od zastosowania, sieć od kilku tysięcy do kilku miliardów tranzystorów. Jego obwody wykonywane są z metali o dobrym przewodnictwie elektrycznym, takich jak aluminium czy miedź.

Jedną z podstawowych cech procesora jest określona długość (liczba bitów) słowa, na którym wykonuje on podstawowe operacje obliczeniowe. Jeśli przykładowo słowo tworzą 64 bity, to taki procesor określany jest jako 64-bitowy. Innym ważnym parametrem określającym procesor jest szybkość, z jaką wykonuje on rozkazy. Przy danej architekturze procesora, szybkość ta w znacznym stopniu zależy od czasu trwania pojedynczego taktu, a więc głównie od częstotliwości jego taktowania.

Nazwa

Procesor bywa też nazywany jednostką centralną, centralną jednostką obliczeniową lub centralną jednostką przetwarzającą (poprzez tłumaczenie angielskiego wyrażenia central processing unit w sposób niemal dosłowny). Część użytkowników „jednostkę centralną” kojarzy jednak z handlowym terminem określającym jednostkę systemową komputera – złożoną z procesora, płyty głównej, kart rozszerzeń, pamięci operacyjnej, dysków twardych i innych elementów zamkniętych we wspólnej obudowie – nieobejmującym urządzeń peryferyjnych (monitora, klawiatury, drukarki).

Budowa

W funkcjonalnej strukturze procesora można wyróżnić:

- zespół rejestrów do przechowywania danych i wyników. Rejestry mogą być ogólnego przeznaczenia lub mają specjalne przeznaczenie.

- jednostkę arytmetyczną (arytmometr) do wykonywania operacji obliczeniowych na danych

- układ sterujący przebiegiem wykonywania programu

- inne układy, w które producent wyposaża procesor w celu usprawnienia jego pracy.

Rozmiary elementów

Jednym z parametrów procesora jest rozmiar elementów budujących jego strukturę. Im są one mniejsze, tym niższe jest zużycie energii, napięcie pracy oraz wyższa możliwa do osiągnięcia częstotliwość pracy. W roku 2012 firma Intel wprowadziła procesory wykonane w procesie technologicznym (fotolitografii) 22 nm (Ivy Bridge), a w czwartym kwartale 2014 było to 14 nm (Core M). W 2019 roku firma AMD wprowadziła na rynek pierwsze procesory o mikroarchitekturze Zen 2 wykonane w litografii 7 nm w fabrykach TSMC.

Aby ograniczyć straty związane z powstawaniem defektów w tak małych strukturach, fabryki procesorów muszą posiadać pomieszczenia o niezwykłej czystości, co jest bardzo kosztownym przedsięwzięciem.

Wielordzeniowość i procesory pomocnicze

Współcześnie większość procesorów ma wielordzeniową budowę. Pierwszym procesorem wielordzeniowym ogólnego przeznaczenia był procesor Power 4 firmy IBM wprowadzony na rynek w roku 2001. Pierwszymi procesorami wielordzeniowymi architektury x86 były wersje procesorów Opteron firmy AMD i Pentium Extreme Edition firmy Intel wprowadzone w kwietniu 2005 roku.

Popularnym modelem firmy Intel, który kontynuował ten trend był Intel Pentium D. Dużą popularność zyskał dopiero Intel Core 2 Duo zbudowany na bazie architektury Conroe (65 nm).

CPU mają rdzenie taktowane zegarem nawet 4,4 GHz (np. AMD A10-6800K i i7-4790k), lecz nie występuje już wyraźny wzrost taktowania w kolejnych generacjach procesorów. Szybkość obliczeń jednak wzrasta dzięki zwiększaniu ilości tranzystorów i rdzeni w procesorach.

Największy konkurent Intela, czyli AMD, wprowadził do sprzedaży popularny model procesora dwurdzeniowego o nazwie Athlon 64 X2. Obie firmy mają dziś w ofercie także modele czterordzeniowe (niektóre Core i5 oraz Core i7 Intela i AMD Athlon II X4 oraz Phenom II X4 AMD) oraz sześciordzeniowe (Phenom II X6 oraz Core i7 serii 9×0) przeznaczone do komputerów klasy desktop. AMD jako pierwsze wprowadziło na rynek procesory ośmiordzeniowe. Od niedawna Intel również posiada taką konstrukcję w ofercie. Jest to procesor i7 5960X o bazowym taktowaniu wynoszącym 3 GHz. Jednostka ta została wykonana w technologii 22 nm, powstała na bazie architektury Haswell (znanej z modeli o oznaczeniach serii 4xxx) i została wydana w trzecim kwartale 2014. Procesory do zastosowań serwerowych mają nawet 16 (AMD Opteron) – 24 rdzenie (Intel Xeon Processor E7 v4 w 2016).

Projektanci procesorów próbują także innych metod zwiększania wydajności procesorów, na przykład hyper-threading, gdzie każdy rdzeń może się zachowywać jak dwa procesory logiczne, dzielące między siebie zasoby pamięci podręcznej i jednostek wykonawczych. Gdy jeden z konkurujących ze sobą procesów pozostawia niewykorzystane zasoby, proces przypisany do drugiego procesora logicznego może ich użyć, co w sprzyjających okolicznościach może prowadzić do sumarycznego wzrostu wydajności od kilku do kilkunastu procent.

W roku 2007 Intel zaprezentował testy układu scalonego Intel Polaris wyposażonego w 80 rdzeni ogólnego przeznaczenia, który osiągnął wydajność 1,01 TFLOPS.

Komputer (w szczególności komputer osobisty) oprócz procesora głównego (CPU) ma zwykle procesory pomocnicze: obrazu (GPU, najnowsze konstrukcje pozwalają na integrację CPU z GPU w APU), dźwięku, koprocesory arytmetyczne (od lat 90. na ogół są zintegrowane z CPU).

Źródło:https://pl.wikipedia.org/wiki/Wikipedia:Strona_g%C5%82%C3%B3wna

Opublikowano Bez kategorii

Skomentuj

Koncentrator sieciowy

Koncentrator sieciowy (także z ang. hub) – urządzenie pozwalające na przyłączenie wielu urządzeń sieciowych do sieci komputerowej o topologii gwiazdy. Najczęściej spotykane w wersji 4-, 8-, 16- lub 24-portowej.

Działanie

Koncentrator pracuje w warstwie pierwszej modelu ISO/OSI (warstwie fizycznej), przesyłając sygnały elektryczne z jednego portu (gniazda) na wszystkie pozostałe. Taka metoda działania nie pozwala mu na analizowanie ramek pod kątem adresu MAC ani datagramów pod kątem adresu IP. Ponieważ koncentrator powiela każdy otrzymany sygnał elektryczny, tworzy tak zwaną domenę kolizyjną – z tego względu czasami koncentrator nazywany jest wieloportowym wzmacniakiem. W sieciach Ethernet najczęściej wykorzystywaną metodą detekcji zaistnienia kolizji jest CSMA/CD. Koncentrator zwykle podłączany jest do routera jako rozgałęziacz, do niego zaś dopiero podłączane są pozostałe urządzenia sieciowe: komputery pełniące rolę stacji roboczych, serwerów, drukarki sieciowe i inne.

Koncentrator a przełącznik

Obecnie urządzenia te nie są już praktycznie stosowane, wyparte zostały przez przełączniki działające w drugiej warstwie modelu ISO/OSI (warstwie łącza danych, wykorzystując adresy MAC podłączonych urządzeń). Powodem takiej sytuacji był bardzo duży spadek cen przełączników, coraz wyższe wymogi dotyczące przepustowości sieci stawiane przez nowoczesne aplikacje sieciowe oraz zwiększające się ilości danych, które muszą być przesłane przez sieć. Duża liczba kolizji występujących w obciążonych sieciach komputerowych powodowała znaczne obniżenie przepustowości i przekreśliła sens stosowania koncentratorów.

Z drugiej strony koncentrator przenosi sygnały z portu wejściowego na wszystkie porty wyjściowe bit po bicie, przełącznik natomiast ramka po ramce, co powoduje powstawanie opóźnień (także dodatkowych, zmiennych, w zależności od długości ramki). Może być to jednak zaletą koncentratora w przypadku bardzo prostych sieci lokalnych.

Źródło:https://pl.wikipedia.org/wiki/Wikipedia:Strona_g%C5%82%C3%B3wna

Opublikowano Bez kategorii

Skomentuj

Topologia sieci komputerowej

Topologia sieci komputerowej – model układu połączeń różnych elementów (linki, węzły itd.) sieci komputerowej. Określenie topologia sieci może odnosić się do konstrukcji fizycznej albo logicznej sieci.[1]

Topologia fizyczna opisuje sposoby fizycznej realizacji sieci komputerowej, jej układu przewodów, medium transmisyjnych. Poza połączeniem fizycznym hostów i ustaleniem standardu komunikacji, topologia fizyczna zapewnia bezbłędną transmisję danych. Topologia fizyczna jest ściśle powiązana z topologią logiczną np. koncentratory, hosty.

Topologia logiczna opisuje sposoby komunikowania się hostów za pomocą urządzeń topologii fizycznej.

Topologie fizyczne

Topologia magistrali (szyny) (ang. bus topology) – wszystkie elementy sieci podłączone są do jednej magistrali. Obecnie stosowana do łączenia urządzeń w topologii punkt-punkt (ang. point-to-point topology).

Topologia liniowa (ang. linear bus topotogy) – odmiana topologii magistrali, w której każdy element sieci (oprócz granicznych) połączony jest dokładnie z dwoma sąsiadującymi elementami.

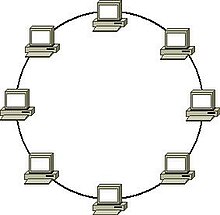

Topologia pierścienia (ang. ring topology) – poszczególne elementy są połączone ze sobą w taki sposób jak w topologii liniowej, a dodatkowo połączone zostały elementy graniczne tworząc zamknięty pierścień.

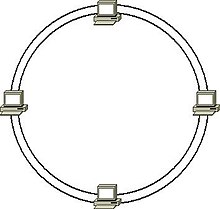

Topologia podwójnego pierścienia (ang. dual ring topology) – odmiana topologii pierścienia, w której poszczególne elementy połączone są ze sobą dwoma przewodami, co pozwala na utworzenie dwóch zamkniętych pierścieni.

Topologia gwiazdy (ang. star topology) – elementy końcowe są podłączone do jednego punktu centralnego, koncentratora(koncentrator tworzy fizyczną topologię gwiazdy, ale logicznie jest to magistrala) lub przełącznika. Stosowana do łączenia urządzeń za pomocą skrętki lub kabla światłowodowego.Każdy pojedynczy kabel jest używany do połączenia z siecią dokładnie jednego elementu końcowego.

Topologia gwiazdy rozszerzonej (ang. extended star topology) – odmiana topologii gwiazdy, posiadająca punkt centralny (podobnie jak w topologii gwiazdy) i punkty poboczne – jedna z częściej stosowanych topologii fizycznych Ethernetu.

Topologia hierarchiczna (ang. hierarchical topology, tree topology, star-bus topology) – zwana także topologią drzewa, jest kombinacją topologii gwiazdy i magistrali, można być także postrzegana jako zbiór sieci w topologii gwiazdy połączonych w strukturę hierarchiczną (drzewiastą).

Topologia siatki (ang. mesh topology) – elementy łączą się bezpośrednio, dynamicznie i niehierarchicznie z jak największą liczbą innych elementów i współpracują ze sobą w celu efektywnego trasowania danych. Sieć w topologii mesh pozwala na dynamiczne samoorganizowanie się i samokonfigurowanie. Rozwiązanie często stosowane w sieciach, w których wymagana jest bezawaryjność.

Źródło:https://pl.wikipedia.org/wiki/Wikipedia:Strona_g%C5%82%C3%B3wna

Opublikowano Bez kategorii

Skomentuj

Router

Router (ruter, po polsku – trasownik, IPA: /’rutɛr/) – urządzenie sieciowe pracujące w trzeciej warstwie modelu OSI. Służy do łączenia różnych sieci komputerowych (różnych w sensie informatycznym, czyli np. o różnych klasach, maskach itd.), pełni więc rolę węzła komunikacyjnego. Na podstawie informacji zawartych w pakietach TCP/IP jest w stanie przekazać pakiety z dołączonej do siebie sieci źródłowej do docelowej, rozróżniając ją spośród wielu dołączonych do siebie sieci. Proces kierowania ruchem nosi nazwę trasowania, routingu lub routowania.

Zarządzanie ruchem

Trasowanie jest najczęściej kojarzone z protokołem IP, choć procesowi trasowania można poddać pakiet dowolnego protokołu trasowanego np. protokołu IPX w sieciach obsługiwanych przez NetWare (sieci Novell).

Budowa

Pierwsze routery z lat sześćdziesiątych były komputerami ogólnego przeznaczenia. Choć w roli routerów można używać zwykłych komputerów, to nowoczesne modele są wysoce wyspecjalizowanymi urządzeniami, w których interfejsy sieciowe połączone są bardzo szybką magistralą wewnętrzną. Wyróżnia się routery modularne (przeznaczone dla operatorów oraz środowisk korporacyjnych) oraz o stałej budowie (zwykle pozycjonowane na brzegu sieci operatorskiej lub dla użytkowników domowych). Routery realizują obsługę ruchu za pomocą procesorów sieciowych (NP) lub wysokospecjalizowanych układów cyfrowych (ASIC/FPGA).

Routery posiadają z reguły wiele różnego rodzaju interfejsów, m.in. Ethernet (od 10 Mbit/s do 10 Gbit/s), ATM, Frame Relay, SONET/SDH czy 3G. W zależności od typu urządzenia, interfejsy znajdują się na osobnych kartach (tzw. kartach liniowych) lub zabudowane na stałe w urządzeniu. Nowoczesne routery brzegowe posiadają wiele różnego rodzaju dodatkowych funkcji – takich jak mechanizmy wspierające funkcje lokalnej centrali wideotelefonii IP, zapory sieciowej, systemu IDS/IPS, optymizacji połączeń w sieciach rozległych itp. Routery szkieletowe budowane są ze zwróceniem szczególnej uwagi na skalowalność – z zachowaniem minimalnych rozmiarów i zapotrzebowania na energię elektryczną i chłodzenie. Coraz częściej routery optymalizowane są pod kątem przetwarzania ruchu Ethernet i IPv4/IPv6.

Przełączniki wielowarstwowe

Szczególnym przypadkiem routera jest przełącznik ethernetowy warstwy trzeciej, czyli urządzenie posiadające wiele interfejsów sieciowych będących logicznym zakończeniem wirtualnej sieci lokalnej (VLAN). Urządzenia te, ograniczone w skalowalności tablic routingu w porównaniu do klasycznych routerów, mają z reguły wysoką wydajność i jednocześnie zajmują bardzo mało miejsca (od 1U w 19-calowej szafie telekomunikacyjnej).

Działanie

Trasowanie musi zachodzić między co najmniej dwiema podsieciami, które można wydzielić w ramach jednej sieci komputerowej. Urządzenie tworzy i utrzymuje tablicę trasowania, która przechowuje ścieżki do konkretnych obszarów sieci oraz metryki z nimi związane (w zależności od zastosowanego protokołu routingu, metryką może być ilość routerów na drodze do miejsca docelowego lub np. wartość będąca złożeniem dostępnej przepustowości, stopy występowania błędów i teoretycznej przepustowości interfejsu).

Skuteczne działanie routera wymaga informacji na temat otaczających go urządzeń – innych routerów i hostów. Może być ona dostarczona w sposób statyczny przez administratora, wówczas nosi ona nazwę tablicy statycznej lub może być pozyskana przez sam ruter od sąsiadujących urządzeń pracujących w trzeciej warstwie; tablice tak konstruowane nazywane są dynamicznymi

Podczas wyznaczania tras dynamicznych router korzysta z protokołów trasowania. Najpopularniejszymi protokołami klasy IGP (wewnętrznymi względem systemu autonomicznego, w którym pracują) są OSPF i IS-IS. Protokołem klasy EGP jest obecnie BGP4.

Źródło:https://pl.wikipedia.org/wiki/Wikipedia:Strona_g%C5%82%C3%B3wna

Opublikowano Bez kategorii

Skomentuj